PyTorch实现卷积神经网络的搭建详解

作者:Bubbliiiing 时间:2021-03-12 16:36:03

PyTorch中实现卷积的重要基础函数

1、nn.Conv2d:

nn.Conv2d在pytorch中用于实现卷积。

nn.Conv2d(

in_channels=32,

out_channels=64,

kernel_size=3,

stride=1,

padding=1,

)

1、in_channels为输入通道数。

2、out_channels为输出通道数。

3、kernel_size为卷积核大小。

4、stride为步数。

5、padding为padding情况。

6、dilation表示空洞卷积情况。

2、nn.MaxPool2d(kernel_size=2)

nn.MaxPool2d在pytorch中用于实现最大池化。

具体使用方式如下:

MaxPool2d(kernel_size,

stride=None,

padding=0,

dilation=1,

return_indices=False,

ceil_mode=False)

1、kernel_size为池化核的大小

2、stride为步长

3、padding为填充情况

3、nn.ReLU()

nn.ReLU()用来实现Relu函数,实现非线性。

4、x.view()

x.view用于reshape特征层的形状。

全部代码

这是一个简单的CNN模型,用于预测mnist手写体。

import os

import numpy as np

import torch

import torch.nn as nn

import torch.utils.data as Data

import torchvision

import matplotlib.pyplot as plt

# 循环世代

EPOCH = 20

BATCH_SIZE = 50

# 下载mnist数据集

train_data = torchvision.datasets.MNIST(root='./mnist/',train=True,transform=torchvision.transforms.ToTensor(),download=True,)

# (60000, 28, 28)

print(train_data.train_data.size())

# (60000)

print(train_data.train_labels.size())

train_loader = Data.DataLoader(dataset=train_data, batch_size=BATCH_SIZE, shuffle=True)

# 测试集

test_data = torchvision.datasets.MNIST(root='./mnist/', train=False)

# (2000, 1, 28, 28)

# 标准化

test_x = torch.unsqueeze(test_data.test_data, dim=1).type(torch.FloatTensor)[:2000]/255.

test_y = test_data.test_labels[:2000]

# 建立pytorch神经网络

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

#----------------------------#

# 第一部分卷积

#----------------------------#

self.conv1 = nn.Sequential(

nn.Conv2d(

in_channels=1,

out_channels=32,

kernel_size=5,

stride=1,

padding=2,

dilation=1

),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2),

)

#----------------------------#

# 第二部分卷积

#----------------------------#

self.conv2 = nn.Sequential(

nn.Conv2d(

in_channels=32,

out_channels=64,

kernel_size=3,

stride=1,

padding=1,

dilation=1

),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2),

)

#----------------------------#

# 全连接+池化+全连接

#----------------------------#

self.ful1 = nn.Linear(64 * 7 * 7, 512)

self.drop = nn.Dropout(0.5)

self.ful2 = nn.Sequential(nn.Linear(512, 10),nn.Softmax())

#----------------------------#

# 前向传播

#----------------------------#

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = x.view(x.size(0), -1)

x = self.ful1(x)

x = self.drop(x)

output = self.ful2(x)

return output

cnn = CNN()

# 指定优化器

optimizer = torch.optim.Adam(cnn.parameters(), lr=1e-3)

# 指定loss函数

loss_func = nn.CrossEntropyLoss()

for epoch in range(EPOCH):

for step, (b_x, b_y) in enumerate(train_loader):

#----------------------------#

# 计算loss并修正权值

#----------------------------#

output = cnn(b_x)

loss = loss_func(output, b_y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

#----------------------------#

# 打印

#----------------------------#

if step % 50 == 0:

test_output = cnn(test_x)

pred_y = torch.max(test_output, 1)[1].data.numpy()

accuracy = float((pred_y == test_y.data.numpy()).astype(int).sum()) / float(test_y.size(0))

print('Epoch: %2d'% epoch, ', loss: %.4f' % loss.data.numpy(), ', accuracy: %.4f' % accuracy)

来源:https://blog.csdn.net/weixin_44791964/article/details/103658845

标签:PyTorch,卷积神经网络,神经网络

猜你喜欢

Docker创建MySQL容器的方法

2024-01-19 13:42:20

python中dict()的高级用法实现

2022-06-16 23:24:29

Mysql CAST函数的具体使用

2024-01-16 16:17:04

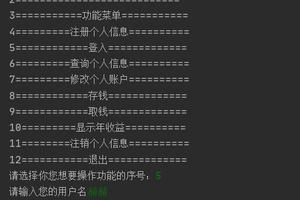

python实现银行账户系统

2023-05-27 17:49:08

利用Python实现RSA加密解密方法实例

2023-10-07 03:10:58

Scrapy-redis爬虫分布式爬取的分析和实现

2023-01-04 10:21:19

Go错误处理之panic函数和recover函数使用及捕获异常方法

2024-02-13 02:16:12

pycharm配置git(图文教程)

2021-10-08 19:09:43

Python数据类型之列表和元组的方法实例详解

2021-01-18 01:56:10

Javascript 回调和事件(翻译)

2009-03-28 11:47:00

python 对xml解析的示例

2023-05-30 23:06:31

Pytorch中的图像增广transforms类和预处理方法

2022-09-10 22:21:06

AspJpeg组件:介绍、注册、高级使用方法

2010-01-25 12:42:00

微信小程序(六):列表上拉加载下拉刷新示例

2024-05-11 09:34:22

Python爬取当网书籍数据并数据可视化展示

2023-11-20 11:31:14

python itertools包内置无限迭代器

2023-11-16 18:58:59

Python第三方库xlrd/xlwt的安装与读写Excel表格

2023-12-16 22:52:34

关于python简单的爬虫操作(requests和etree)

2022-01-08 02:17:27

Python可视化学习之matplotlib内置单颜色

2021-07-27 06:43:46

mysql 中文乱码 解决方法集锦

2024-01-28 06:05:29